![]() STARTSEITE -->

KURS INFORMATIONSVERARBEITUNG --> MODUL B: ADMINISTRATION --> LEKTION 1: EINFÜHRUNG

HARDWARE

STARTSEITE -->

KURS INFORMATIONSVERARBEITUNG --> MODUL B: ADMINISTRATION --> LEKTION 1: EINFÜHRUNG

HARDWARE

Diese Lektion gibt Ihnen einen groben Überblick über die unterschiedlichen Komponenten eines Rechners und deren Aufgaben. Im Alltag ist der Umgang damit wesentlich wichtiger als die tiefe Kenntnis der Funktionsweisen. Wenn Sie dennoch mehr in die Tiefe gehen wollen, finden Sie nach jeder Komponente entsprechende Wikipedia-Links zur Vertiefung.

Generell gibt es zwischen den Komponenten in Servern und einfachen PCs erst einmal keinen Unterschied. Sie unterscheiden sich häufig nur durch die Leistungsfähigkeit und eine aufwändigere Verarbeitung. In Servern arbeiten dann zusätzlich oft noch einige Komponenten, die Ihnen bei der Administration das Leben erleichtern.

Die Zentraleinheit oder schlicht "der Rechner" besteht im Wesentlichen aus folgenden Elementen:

In der Grafik von links nach rechts:

Die meisten Gehäuse bieten auf ihrer Vorderseite Einschübe für Laufwerke und anderen Erweiterungen. Auf dem Bild sind beim Towergehäuse sehr schön die vier breiten 5,25-Zoll-Einschäube für optische Laufwerke und zwei 3,5-Zoll-Einschübe für Diskettenlaufwerke oder Kartenleser zu erkennen.

|

In der Grafik von links nach rechts:

![]() Artikel "Notebook"

Artikel "Notebook"

![]() Artikel "Tabletcomputer"

Artikel "Tabletcomputer"

Am Gehäuse befinden sich in der Regel folgende

Bedienelemente: der Einschalter und der Reset-Taster. Der Ein-/Ausschalter schaltet das Gerät ein oder fährt es herunter. Da seine Funktion softwaregesteuert ist, kann man im Betriebssystem

einstellen, ob er den Rechner herunterfährt, den Ruhezustand auslöst oder lediglich in den Standby-Modus wechselt. Reagiert der Rechner nicht mehr, kann der Schalter für einige Sekunden gedrückt

werden um das System hart auszuschalten. Mit Hilfe des Reset-Tasters kann der Rechner, für den Fall, dass er abgestürzt sein sollte, neu gestartet werden. Er unterbricht die Stromzufuhr zur

Hauptplatine, was unweigerlich dazu führt, dass der Rechner alle im Arbeitsspeicher befindlichen Informationen vergisst und neu startet. Oft wird der Taster versenkt eingebaut, sodass er nur mit

einer Kugelschreibermine oderähnlichem aktivierbar ist und dass ein versehentliches Auslösen ausgeschlossen ist. Der Reset-Taster ist auf mobilen Systemen normalerweise nicht verfügbar, dafür

aber in der Regel ein Schalter zur Aktivierung oder Deaktivierung des WLAN-Moduls.

Am Gehäuse befinden sich in der Regel folgende

Bedienelemente: der Einschalter und der Reset-Taster. Der Ein-/Ausschalter schaltet das Gerät ein oder fährt es herunter. Da seine Funktion softwaregesteuert ist, kann man im Betriebssystem

einstellen, ob er den Rechner herunterfährt, den Ruhezustand auslöst oder lediglich in den Standby-Modus wechselt. Reagiert der Rechner nicht mehr, kann der Schalter für einige Sekunden gedrückt

werden um das System hart auszuschalten. Mit Hilfe des Reset-Tasters kann der Rechner, für den Fall, dass er abgestürzt sein sollte, neu gestartet werden. Er unterbricht die Stromzufuhr zur

Hauptplatine, was unweigerlich dazu führt, dass der Rechner alle im Arbeitsspeicher befindlichen Informationen vergisst und neu startet. Oft wird der Taster versenkt eingebaut, sodass er nur mit

einer Kugelschreibermine oderähnlichem aktivierbar ist und dass ein versehentliches Auslösen ausgeschlossen ist. Der Reset-Taster ist auf mobilen Systemen normalerweise nicht verfügbar, dafür

aber in der Regel ein Schalter zur Aktivierung oder Deaktivierung des WLAN-Moduls.

Am Gehäuse können verschiedene (manchmal auch individuelle) Anzeigen untergebracht sein. Gängig sind Leuchtdioden für Stromversorgung, Festplattenzugriff und manchmal für Datentransfer über den

Netzwerkadapter, Bluetooth und WLAN. Eine Auswahl der dazugehörigen Symbole sehen Sie rechts.

An Ihrem Computer befinden sich diverse Anschlüsse, mit denen Sie beispielsweise Peripheriekomponenten anschließen können. Die häufigsten Anschlussarten sind:

Der wichtigste Anschluss für externe Geräte ist der USB-Anschluss. Damit ist es möglich unzählige Peripheriekomponenten von Maus und Tastatur über Festplatten, Kameras und Smartphones bis hin

zu Tassenwärmern oder Ventilatoren an einen Computer anzuschließen. Der Name deutet ja schon darauf hin, dass er nicht einem bestimmten Zweck dient, sondern als universeller Anschluss für

Plug & Play-Geräte gedacht ist.

Der wichtigste Anschluss für externe Geräte ist der USB-Anschluss. Damit ist es möglich unzählige Peripheriekomponenten von Maus und Tastatur über Festplatten, Kameras und Smartphones bis hin

zu Tassenwärmern oder Ventilatoren an einen Computer anzuschließen. Der Name deutet ja schon darauf hin, dass er nicht einem bestimmten Zweck dient, sondern als universeller Anschluss für

Plug & Play-Geräte gedacht ist.

Veraltete Anschlüsse

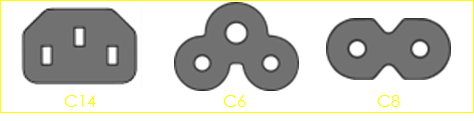

Veraltete AnschlüsseDas Netzteil versorgt alle Komponenten des Rechners mit Energie. Bei stationären Rechnern gibt es manchmal am Netzteil einen Hauptschalter, mit dem man das System physisch vom Stromnetz trennen kann. Die möglichen Anschlussarten sind in der IEC Norm 60320 geregelt. Stationäre Rechner werden in der Regel einen IEC C14-Anschluss (Kaltgerätelkabel) mit Strom versorgt. Mobile Systeme haben in der Regel ein externes Netzteil, dass entweder über einen C6-Anschluss (Kleeblattstecker) oder über einen C8-Anschluss (Eurostecker) verfügt. Wichtig ist, dass das Netzteil zu den Leistungsdaten der verbauten Komponenten passt.

![]() Artikel "Netzteil" Abschnitt "Einbau-Netzteil"

Artikel "Netzteil" Abschnitt "Einbau-Netzteil"

![]() Artikel "Gerätestecker" Abschnitt "Tabellarische Übersicht"

Artikel "Gerätestecker" Abschnitt "Tabellarische Übersicht"

Die

Hauptplatine (engl. "Mainboard", auch "Motherboard") ist mit ihren Leiterbahnen sozusagen das Nervensystem eines Rechners. Auf der Platine befinden außerdem einige wichtige

Chips, die entweder aufgesteckt oder aufgelötet sind. Erweiterungen wie Grafikkarten, Netzwerkkarten, Soundkarten und werden über so genannte Slots in die Platine eingesteckt. Heute ist

normalerweise eine PCI-Slot (PCI= Peripheral Component Interface) vorhanden. Grafikkarten verwenden in der Regel den PCI Express 16 Slot und Erweiterungskarten für USB 3.0-Adapter werden meist

über den PCI-Express-1-Port angesteuert.

Die

Hauptplatine (engl. "Mainboard", auch "Motherboard") ist mit ihren Leiterbahnen sozusagen das Nervensystem eines Rechners. Auf der Platine befinden außerdem einige wichtige

Chips, die entweder aufgesteckt oder aufgelötet sind. Erweiterungen wie Grafikkarten, Netzwerkkarten, Soundkarten und werden über so genannte Slots in die Platine eingesteckt. Heute ist

normalerweise eine PCI-Slot (PCI= Peripheral Component Interface) vorhanden. Grafikkarten verwenden in der Regel den PCI Express 16 Slot und Erweiterungskarten für USB 3.0-Adapter werden meist

über den PCI-Express-1-Port angesteuert.

Außerdem beherbergt die Hauptplatine Steckplätze für Arbeitsspeichermodule und den Sockel, in den der Hauptprozessor eingesteckt wird.

Wegen der unterschiedlichen Baugrößen von PCs gibt es

auch unterschiedliche Formfaktoren für Platinen. Die genauen Spezifikiationen der Formfaktoren können Sie der Seite

![]() Details

entnehmen.

Details

entnehmen.

Der Hauptprozessor ("central processing unit", CPU) ist das rechnende Gehirn jedes

Rechners. Im eigentlichen Prozessorchip (engl. "die" [

Der Hauptprozessor ("central processing unit", CPU) ist das rechnende Gehirn jedes

Rechners. Im eigentlichen Prozessorchip (engl. "die" [![]() 3]) befinden sich normalerweise

mehrere unabhängige Rechenkerne (engl. "cores").

3]) befinden sich normalerweise

mehrere unabhängige Rechenkerne (engl. "cores").

Aktuelle Prozessoren sind in der Regel mit einer Busbreite [![]() 4] von 64-Bit ausgestattet. Ihre

Arbeitsgeschwindigkeit hängt neben der Busbreite aber auch von der Taktung des Prozessors ab. Die Maßeinheit der Geschwindigkeit ist in Hertz (Hz) angegeben. (1 Hz entspricht einer Aktion pro

Sekunde) Heutige Prozessoren arbeiten im Bereich mehrerer Gigahertz (GHz). Demnach werden pro Sekunde mehrere Milliarden Datentransaktionen pro Prozessorkern durchgeführt.

4] von 64-Bit ausgestattet. Ihre

Arbeitsgeschwindigkeit hängt neben der Busbreite aber auch von der Taktung des Prozessors ab. Die Maßeinheit der Geschwindigkeit ist in Hertz (Hz) angegeben. (1 Hz entspricht einer Aktion pro

Sekunde) Heutige Prozessoren arbeiten im Bereich mehrerer Gigahertz (GHz). Demnach werden pro Sekunde mehrere Milliarden Datentransaktionen pro Prozessorkern durchgeführt.

Während des Betriebs erwärmt sich der Prozessor stark. Überhitzt er, führt das zu Systeminstabilität und falschen Rechenergebnissen bis hin zum endgültigen Totalausfall des Rechners. Deswegen

wird jeder Prozessor mit einem Kühlkörper und mit einem Ventilator versehen, die ihn kühlen. Zwischen Kühlkörper und Prozessor wird zusätzlich noch dünn eine Wärmeleitpaste aufgetragen.

Alternativ (und deutlich teurer) ist eine Wasserkühlung erhältlich. In Rechenzentren wird dazu gleich der ganze Serverraum aktiv gekühlt.

Sämtliche Daten, ob frisch errechnet oder aus einer Datei

gelesen, die auf einem Laufwerk liegt, werden vom System im sogenannten Arbeitsspeicher (RAM, Random Access Memory) vorgehalten. Vorteil dieses Speichers ist, dass die Daten quasi in Echtzeit

verfügbar sind und anders als beim Einladen der Daten von der Festplatte keine (merkliche) Antwortzeit entsteht. Arbeitsspeicher ist flüchtig, das heißt er "vergisst" seine Daten,

sobald das System abstürzt oder vom Strom getrennt wird.

Sämtliche Daten, ob frisch errechnet oder aus einer Datei

gelesen, die auf einem Laufwerk liegt, werden vom System im sogenannten Arbeitsspeicher (RAM, Random Access Memory) vorgehalten. Vorteil dieses Speichers ist, dass die Daten quasi in Echtzeit

verfügbar sind und anders als beim Einladen der Daten von der Festplatte keine (merkliche) Antwortzeit entsteht. Arbeitsspeicher ist flüchtig, das heißt er "vergisst" seine Daten,

sobald das System abstürzt oder vom Strom getrennt wird.

Im System wird er als DIMM oder SoDIMM-Speichermodul eingebaut. Speichermodule stehen in unterschiedlichen Speichergrößen

(4 GB, 8 GB, 16 GB usw.) sowie -generationen (DDR, DDR II, DDR III, DDR IV usw.) zur Verfügung.

![]() Artikel "Dual Inline Memory Module"

Artikel "Dual Inline Memory Module"

Die Menge des im Betriebssystem nutzbaren Speichers unterscheidet sich möglicherweise vom tatsächlich eingebauten Speicher. Das liegt unter anderem daran, dass 32-Bit-Installationen einen maximal ansprechbaren Adressraum von 4 GB haben. Wenn ihr System über mehr als 4 GB Speicher verfügt oder Sie später aufrüsten möchten, sollten Sie daher immer 64 GB Betriebssystem installieren.

Der Chipsatz besteht in der Regel aus zwei, auf der Hauptplatine aufgelöteten integrierten Schaltkreisen. Es hat technische Gründe, unter anderem die Anzahl der benötigten elektrischen Anschlüsse, dass man die Funktionen des Chipsatzes normalerweise nicht auf einem einzigen Chip unterbringen kann. Lediglich der Chipsatz "nForce4" von nVidia ist auf einem Chip konzentriert. Sonst steuern zwei Chips den Datentransfer der einzelnen Komponenten der Hauptplatine und der Peripheriegeräte. Sie werden als "Northbridge" und "Soutbridge" bezeichnet.Der Chip der Northbridge enthält in der Regel komplexere Funktionen (Steuerung von Datentransfer zwischen Prozessor und Arbeitsspeicher / Cache als der Chip der Southbridge. Deshalb werden dort häufig weitere Funktionen (Soundsteuerung etc.) zusätzlich integriert. Die Chips tragen Ihre Namen aufgrund der Anordnung auf der Platine. Weiter "oben" (also "nördlich" näher an der CPU) sitzt die Northbridge. Der kurze Weg zwischen dem Chip und der CPU ist für die Übertragung von Vorteil, was Zuverlässigkeit und Geschwindigkeit angeht. Die Southbridge befindet sich ein wenig weiter weg von der CPU und trägt daher Ihren Namen. Sie steuert den Datentransfer der PCI-Slots und ist daher diesen näher. Intel nennt die Southbridge "I/O Controller Hub".

![]() Artikel "Chipsatz"

Artikel "Chipsatz"

![]() Artikel

"Integrierter Schaltkreis"

Artikel

"Integrierter Schaltkreis"

Dieser Chip enthält das grundlegende uEFI-System, das beim Systemstart alle Geräte und Datenträger initialisiert und für den reibungslosen Systemstart sorgt. Bei älteren Systemen ist anstelle

des uEFIs noch dessen Vorläufer der "BIOS-CMOS" verbaut.

Seine Aufgabe ist es, die Grundeinstellungen des Rechners auf unterster Ebene zu steuern. Darunter fallen insbesondere die Anzahl und Art der angeschlossenen Laufwerke und deren Bootreihenfolge,

die Systemzeit, rudimentäres Speichermanagement und Systempasswörter. Dabei handelt es sich im Prinzip um ein änderbares Programm, das in einen kleinen Chip auf der Hauptplatine untergberacht ist.

Werden hier falsche Angabe (gerade zur Art der Festplatte) gemacht, kann dies dem System irreparable Schäden zufügen.

Während die Einstellungen des BIOS früher im EPROM permanent gespeichert waren, werden sie heute meist in einem EEPROM abgelegt.[![]() 5]

Das klassische EPROM ist mittlerweile für den Markt nahezu bedeutungslos geworden.[

5]

Das klassische EPROM ist mittlerweile für den Markt nahezu bedeutungslos geworden.[![]() 6] Der Vorteil

dabei ist, dass das BIOS aktualisiert werden kann ("flashing") ohne den Chip tauschen zu müssen. Der Nachteil dabei ist, dass die Daten flüchtig dort hinterlegt sind. Das bedeutet:

Sollte die Batterie auf dem Motherboard ausfallen, vergisst das Programm nicht nur die Angaben über die Systemzeit und die installierten Laufwerke, sondern auch alle weiteren Einstellungen.

6] Der Vorteil

dabei ist, dass das BIOS aktualisiert werden kann ("flashing") ohne den Chip tauschen zu müssen. Der Nachteil dabei ist, dass die Daten flüchtig dort hinterlegt sind. Das bedeutet:

Sollte die Batterie auf dem Motherboard ausfallen, vergisst das Programm nicht nur die Angaben über die Systemzeit und die installierten Laufwerke, sondern auch alle weiteren Einstellungen.

Bereits seit 1998 wurde von Intel die Idee verfolgt, das BIOS durch ein System abzulösen, das benutzerfreundlicher sein sollte und nicht immer vollständig geladen werden musste, sondern nur die

Teile, die auch tatsächlich benötigt werden. Außerdem sollte ein Zugriff per Netzwerk zur Administrationserleichterung möglich sein. Seit Anfang 2006 mit der wird das System als uEFI (unified

Extensible Firmware Interface) bzw. EFI 2.0 von Intel vertrieben. Eine Durchdringung des Marktes fand erst statt, als Apple bei seinen Systemen ausschließlich auf EFI setzte. Windows unterstützt

seit Vista mit Service Pack 1 diese Architektur und fordert sie seit Windows 8.[![]() 7]

7]

|

Genauere Infos zum BIOS finden Sie unter: → http://www.bios-info.de/bios/compend.htm

![]() Artikel "Unified Extensible Firmware Interface"

Artikel "Unified Extensible Firmware Interface"

Aufgabe des Grafikchips ("graphics processing unit", GPU) ist es,die Ausgaben für den Monitor vorzubereiten. Der Chip kann entweder auf der Hauptplatine oder auf einer eigenen Steckkarte, der Grafikkarte, untergebracht sein. Er benötigt zur Berechnung seiner Graphikausgaben Arbeitsspeicher. In einfachen Systemen wird dieser Arbeitsspeicher vom normalen Systemarbeitsspeicher genommen ("shared memory"-Grafik), in teureren Systemen verfügt er über eigenen dedizierten Speicher (GDDR). Gängige Speichergrößen sind heute 4, 8, 12 oder 16 GB GDDR V-Speicher. Topmodelle wie die NVIDIA M6000 bieten bis zu 24 GB eigenen Speichers.

Analog zur Grafikkarte erzeugt die Soundkarte ausgabenüber die extern angeschlossenen Lautsprecher. Sie ist nicht verantwortlich für das Piepsen des Systemlautsprechers. Je nach Preis und Hersteller ist divergiert die Ausstattung ganz erheblich. In der Regel bieten aber alle Modelle zumindest folgende Anschlussmöglichkeiten: Auch hier gibt es, hauptsächlich für professionelle Anwender wie Tonstudios, Soundkarten, deren Ausstattung deutlich über den auf der Hauptplatine aufgelöteten Chip hinausgeht.

g. Kurzschlussbrücken (Jumper):

g. Kurzschlussbrücken (Jumper):Kurzschlussbrücken oder Jumper verbinden zwei Stifte auf eine Platinen und lösen damit vorherbestimmte Funktionen aus. Als Akronym wird auf die Platinen meist J X bzw. JP X verwendet, wobei X für die Nummer des Jumper steht. Zum Anzeigen eines Fotos zum Thema Jumper bitte auf das Schema klicken. An Stelle der Jumper können äußerst selten auch Miniaturschalter auf der Platine aufgelötet sein. Man spricht dann von DIPs.

![]() Artikel

"Jumper (Elektrotechnik)"

Artikel

"Jumper (Elektrotechnik)"

"Massenspeicher-Medien" ermöglichen das dauerhafte und Ablegen von Daten - unabhängig davon, ob das Medium gerade mit Strom versorgt wird oder nicht. Es gibt unterschiedliche Technologien, die dabei zum Einsatz kommen, zum Beispiel: Aktuell sind Festplattenlaufwerke, Flash-Speicher und Solid State Drives noch verbreitet. Optische Medien wie BluRays, DVDs oder CDs verlieren rapide an Bedeutung.

Beispiele für Flash-Speicher sind:

Beispiele für Magnet-Speicher sind:

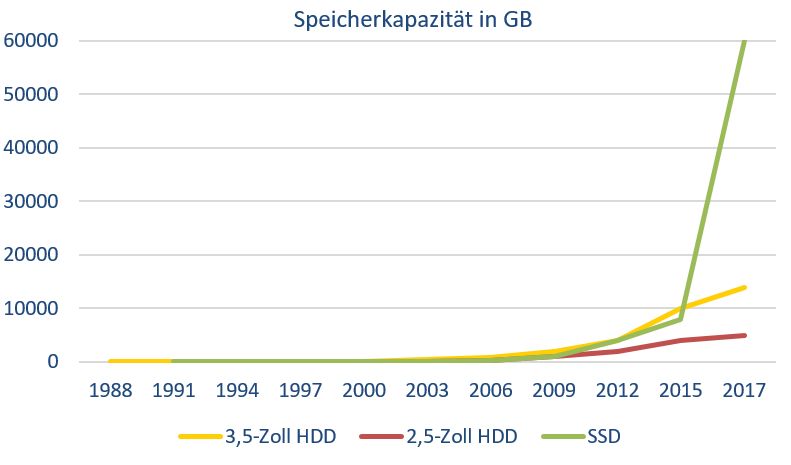

Die Entwicklung der Speicherkapazität beschreibbarer Speichermedien zeigt eindrucksvoll das explosionsartige Wachstum der größten verfügbaren Laufwerke

Als optische Laufwerke bezeichnet man Laufwerke wie CD-, DVD-

oder BluRay-Drives. Die Daten werden bei der Herstellung in einer spiralförmigen Spur von innen nach außen, also anders als bei einer Schallplatte, auf die Trägerplatte des Datenträgers gebrannt.

In bestimmten Abständen können Vertiefungen eingebrannt sein. Eine Vertiefung ("pit") bedeutet 1, keine Vertiefung ("land") 0. Auf einer Standard CD-ROM haben so etwa 600

Millionen Zeichen Platz.[

Als optische Laufwerke bezeichnet man Laufwerke wie CD-, DVD-

oder BluRay-Drives. Die Daten werden bei der Herstellung in einer spiralförmigen Spur von innen nach außen, also anders als bei einer Schallplatte, auf die Trägerplatte des Datenträgers gebrannt.

In bestimmten Abständen können Vertiefungen eingebrannt sein. Eine Vertiefung ("pit") bedeutet 1, keine Vertiefung ("land") 0. Auf einer Standard CD-ROM haben so etwa 600

Millionen Zeichen Platz.[![]() 8] Ein gebündelter Laserstrahl erkennt nun die Vertiefungen (weil keine

direkte Reflexion erfolgt), gibt diese Informationen an einen Controller, welcher dann einen Datensatz im Arbeitsspeicher aufbaut. Die Lesegeschwindigkeit weicht je nach Gerät ab und wird in

X-Fach-Werten angegeben, wobei sich der Einfachwert (single speed) von Medium zu Medium unterscheidet. Die entsprechenden Vielfachen sind also errechenbar... 50-fache CD-Geschwindigkeit

bedeutet also 50x150Kilobyte= 7500 Kilobyte pro Sekunde (also etwa 7,32 Megabyte Datendurchsatz).

8] Ein gebündelter Laserstrahl erkennt nun die Vertiefungen (weil keine

direkte Reflexion erfolgt), gibt diese Informationen an einen Controller, welcher dann einen Datensatz im Arbeitsspeicher aufbaut. Die Lesegeschwindigkeit weicht je nach Gerät ab und wird in

X-Fach-Werten angegeben, wobei sich der Einfachwert (single speed) von Medium zu Medium unterscheidet. Die entsprechenden Vielfachen sind also errechenbar... 50-fache CD-Geschwindigkeit

bedeutet also 50x150Kilobyte= 7500 Kilobyte pro Sekunde (also etwa 7,32 Megabyte Datendurchsatz).

Optische Medien gibt es als:

Die Medien werden in unterschiedlichen Abmessungen vertrieben und haben dann eine entsprechend geringere oder höhere Speicherkapazität. Optische Medien verlieren derzeit wegen der stetig verbesserten Möglichkeit, sogar Filme in hoher Qualität über das Internet zu streamen, massiv an Bedeutung.

![]() Artikel "Compact Disc"

Artikel "Compact Disc"

![]() Artikel "DVD"

Artikel "DVD"

![]() Artikel "Blu-ray Disc"

Artikel "Blu-ray Disc"

Sonstige Speichermedien haben im Privat-Anwender-Bereich nur äußerst geringe Verbreitung gefunden. Zu ihnen zählen vor allem Medien, wie Magnetbänder, die zur Erstellung von Sicherheitskopien dienen. Es gab und gibt darüberhinaus viele experimentelle Speichermedien, die sich bislang aber nicht durchsetzen konnten.

Unter Peripherie versteht man alle externen

Geräte und Einheiten, die an einen Rechner angeschlossen werden können. Einige dienen der Kommunikation zwischen Anwender und Rechner ("E/A-Geräte" für Eingabe/Ausgabe oder englisch

"I/O-Devices" für input/output). Aber auch andere Geräte wie zum Beispiel Kartenzahlungs-Terminals, Scanner oder Drucker werden als Peripherie bezeichnet.

Unter Peripherie versteht man alle externen

Geräte und Einheiten, die an einen Rechner angeschlossen werden können. Einige dienen der Kommunikation zwischen Anwender und Rechner ("E/A-Geräte" für Eingabe/Ausgabe oder englisch

"I/O-Devices" für input/output). Aber auch andere Geräte wie zum Beispiel Kartenzahlungs-Terminals, Scanner oder Drucker werden als Peripherie bezeichnet.

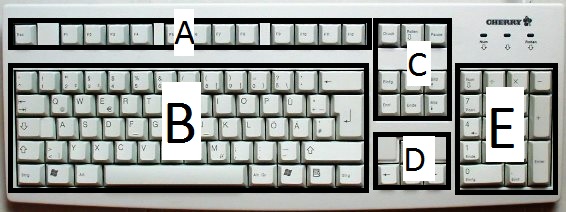

Die heute gebräuchliche PC-Tastatur basiert auf der genormten

102-Tasten Multifunktionstastatur MF2. Sie wurde mit der Einführung von Windows 95 um drei Windows-spezifische Tasten erweitert und ist seitdem weitgehend unverändert geblieben. Mit der Tastatur

können Sie Eingaben machen und den Computer steuern. Viele Befehle lassen sich über Tastenkombinationen sogar deutlich schneller erledigen als mit der Maus. Die Tastatur ist in 5 Blöcke

unterteilt:

Die heute gebräuchliche PC-Tastatur basiert auf der genormten

102-Tasten Multifunktionstastatur MF2. Sie wurde mit der Einführung von Windows 95 um drei Windows-spezifische Tasten erweitert und ist seitdem weitgehend unverändert geblieben. Mit der Tastatur

können Sie Eingaben machen und den Computer steuern. Viele Befehle lassen sich über Tastenkombinationen sogar deutlich schneller erledigen als mit der Maus. Die Tastatur ist in 5 Blöcke

unterteilt:

In der Reihe ganz oben befinden sich 12 Funktionstasten und die ESC(Escape)-Taste. Die Funktionstasten haben keine feste Funktion, sondern werden von jedem Programm mit gerade benötigten Funktionen ausgestattet. In der Regel jedoch bedeutet die Taste F1 "Hilfe", die Taste "F3" ruft eine Suchfunktion auf und die Taste F12 bedeutet "Speichern und Beenden". Aber wie gesagt das muss nicht so sein. Die Esc-Taste funktioniert auch nur eingeschränkt. Sie soll unerwünschte Dialogfelder ausblenden oder Programme anhalten bzw. abbrechen.

Unterhalb der Funktionstastenreihe befindet sich der Schreibmaschinenblock. Dieser hat dann auch genau die Funktion einer Schreibmaschine. Hinzu kommen im unteren Bereich noch zwei Steuerungstasten (Strg oder Ctrl), sowie eine Alt- und eine Alt-Gr-Taste sowie die besagten Windows-Tasten. Wie bei jeder Schreibmaschine auch gibt es eine Hochstellfunktionalität (shift) mit Einrastfunktion (caps lock), ist eine der beiden aktiviert erhält man entweder Großbuchstaben oder das Zeichen, das über dem eigentlichen Zeichen auf der Taste abgebildet ist. Bei aktivierter Einrastfunktion leuchtet am oberen rechten Tastaturrand eine Kontrollleuchte mit. Auf den Tasten F und J befindet sich jeweils eine Erhöhung um ein taktiles Feedback zu erhalten, das bei Menschen, die Blindschreiben gelernt haben unabkömmlich ist. Die Alt-Gr-Taste bewirkt ähnlich der Hochstelltaste, dass das Zeichen des rechts neben des Standardzeichens einer Taste aufgedruckt ist erscheint. (Zum Beispiel bewirkt AltGr+E das Euro-Symbol, AltGr+Q das "@" und AltGr+7 eine öffnende geschweifte Klammer usw.) Die Strg-Tasten sind Kombinationstasten, die nur mit einer zweiten Taste eine Funktionalität bekommen. Je nachdem welche zweite Taste das ist, sind unterschiedliche Systemfunktionen hinterlegt, die sonst über die Menüsteuerung erreichbar sind. Viele Programme bieten noch die Möglichkeit die Tastenkombinationen individuell anzupassen. Diese Kombinationen werden Tastenkürzel oder englisch "shortcuts" genannt. Einige häufige Kombinationen sind Strg+P (Drucken/Print), Strg+S (Speichern/ Save), Strg+O (öffnen/Open) und Strg+C (Schließen/Close). Die entsprechenden Tastenkürzel sind aber meistens im Menü hinter dem jeweiligen Befehl angegeben.

Die Alt-Taste ist genau wie die Strg-Taste eine Kombinationstaste. Sie erlaubt es auch ohne die Maus die Menüleiste zu aktivieren. Wird sie allein gedrückt wird meist der erste Menüpunkt (oft ist das "Datei") markiert. Das welche Tasten dazu in Kombination gedrückt werden können wird im Menü durch Unterstriche unter bestimmten Buchstaben verdeutlicht. Eine wichtige Tastenkombination in Windows ist in diesem Zusammenhang ist Alt+F4 (Beenden).

Rechts vom Schreibmaschinenblock befindet sich ein Block aus 9 Tasten. Die rechten Vier dienen hauptsächlich der Steuerung innerhalb von Dokumenten. (seitenweises Blättern, Position 1, Endposition des Cursors) Eine Kombination mit der Strg-Taste ist möglich. Sie bewirkt, dass die Einfügemarke statt zum Zeilenanfang an den Dokumentenbeginn und statt zum Zeilenende zum Dokumentenende springt. Die ersten beiden Tasten (Einfg und Entf) werden im 2. und 3. Thema näher beschrieben. Sie dienen der Kopie von Elementen in den Arbeitsspeicher und dem späteren Einfügen, sowie dem Löschen von Elementen. Darüber hinaus befinden sich noch drei weitere Tasten (Pause, Druck, Rollen) in der obersten Reihe. Ihre Funktion ist eher untergeordnet. Einzig die Druck-Taste sei noch erwähnt. Sie erzeugt ein Bild der Arbeitsoberfläche im Systemspeicher, das dann in Dokumente etc. eingefügt werden kann. In Kombination mit der Alt oder Alt-Gr-Taste erzeugt sie lediglich ein Bild des aktiven Fensters im Arbeitsspeichers, das ebenfalls in Dokumente eingefügt werden kann.

Die Cursortasten bewegen die Einfügemarke (Cursor) in die vom Pfeil angegebene Richtung. Auch hier ist eine Kombination mit der Strg-Taste möglich. Sie führt dazu, dass der Cursor nicht nur um einen Buchstaben, sondern um ein Wort in die angegebene Richtung springt (Cursortasten rechts und links) bzw. an den Absatzbeginn oder an das Absatzende (Cursortasten aufwärts und abwärts.

Der Ziffernblock befindet sich ganz rechts auf der Tastatur und erleichtert die Eingabe von Zahlen, was gerade in Kalkulationen (Excel, Rechnerfunktion...) sehr effektiv sein kann. Er muss jedoch zunächst eingeschaltet werden (kannüber das BIOS voreingestellt sein). Dazu ist die Taste ganz oben links mit der Beschriften "Num" einmal zu betätigen. Eine Kontrollleuchte am oberen Tastaturrand zeigt nun die Funktionsbereitschaft des Nummernblocks an. Ist er abgeschaltet, so sind die Tasten mit Bewegungsfunktionen (siehe Cursortasten und Kommandotastenblock) belegt.

Prinzipiell gibt es kaum einen Unterschied in der Funktionsweise aller Zeigegeräte. Es ist wohl einzig dem Anwenderüberlassen, für welches Gerät er sich entscheidet. Sie alle haben gemeinsam, dass sie die Position des Zeigers auf dem Bildschirm frei verändern können und mit Hilfe von mindestens zwei Tasten eine Auswahl oder eine Funktion aufrufen können.

Seit Mitte der 80er Jahre die ersten grafischen Benutzeroberflächen aufkamen, wurde die Maus zum unverzichtbaren Werkzeug in der täglichen Arbeit mit dem Rechner.

Es gibt kabelgebundene (wired) und kabellose (wireless) Mäuse (mit Infrarot- und Funktechnologie). Ein kleines Rädchen in der Mitte erlaubt das herauf- und herunterrollen des Bildschirminhalts. Klickt man auf das Rädchen verwandelt sich der Mauszeiger und man kann den Bildschirm durch bloßes Verschieben der ganzen Maus bewegen. Die neuesten Mausmodelle lassen das Seitwärtsscrollen mit dem Rädchen zu. Hat man diese edle Funktion nicht, kann man auch die Shift-Taste auf der Tastatur während des Scrollens halten. Der Effekt ist der Gleiche. Hält man übrigens die Strg-Taste während das Rädchen gedreht wird, verändert man den Zoom-Wert des aktiven Fensters.

Auf der Unterseite kann eine kleine Kugel zu sehen sein, die die Bewegungsrichtung mechanisch auf kleine Wellen überträgt. Dies wäre die klassische Methode die Bewegungen der Maus abzugreifen. Die zweite Möglichkeit die Bewegungen der Maus umzusetzen bieten so genannte optische Mäuse. Auf ihrer Unterseite sendet eine starke Leuchtdiode einen dauerhaften Lichtimpuls in Richtung Tischoberfläche, der von dort reflektiert wird. Die Lichtreflexion wird über einen Fotosensor aufgenommen und von einem Chip ausgewertet. Dieser gibt die Bewegungsinformation nun an den Rechner weiter. Optische Mäuse funktionieren auf Glastischen wegen der schlechten Reflektionswerte nur schlecht, sind jedoch ansonsten ruckfreier als Kugelmäuse. Prinzipiell genauso funktionieren Lasermäuse. Hier liegt wird jedoch statt einer normalen Leuchtdiode Laserlicht verwendet. Mit dieser Technik lässt sich eine deutlich höhere Präzision erreichen.

b. Trackball

b. TrackballDer Trackball kam zunächst nur bei Laptops vor. Im Prinzip bedient man ihn so als hätte man eine Maus mit Kugel auf dem Rücken liegend vor sich. Jede Drehbewegung am Ball wird entsprechend durch den Rechner umgesetzt.

Das Touchpad ist eine unscheinbare, ebene Fläche über die der Anwender mit dem Finger streicht um den Mauszeiger zu verschieben. Touchpads kommen fast ausschließlich bei Laptops vor, obwohl es auch Pads als echten Mausersatz für fest stehende Rechner gibt (z.B. Apples Trackpad). Moderne Touchpads können mehr als einen Berührungspunkt erkennen und beherrschen Gestensteuerung. Dabei erkennen sie zum Beispiel Befehle für hinein- und herauszoomen. Hineinzoomen wird ausgelöst, wenn man zwei Finger eng aneinander auf dem Touchpad auflegt und dann auseinander spreizt, herauszoomen wird ausgelöst, wenn man die Finger gespreizt auf das Touchpad legt und sie dann zusammenführt. Andere Gesten sind zum Beispiel der Befehl "zurück" wenn man schnell mit einem Finger gegen den Uhrzeiger sind auf dem Pad einen Kreis nachzeichnet. Bei einigen Notebooks wird das Touchpad durch eine weitere Navigation, den Trackpoint ergänzt. Wie auf dem Bild rechts zu sehen befindet er sich zwischen den Tasten b,n,g und h auf der Tastatur. Der Trackpoint wird zum Bewegen der Maus in die gewünschte Richtung gedrückt.

Das Prinzip des Touchscreens ist genial einfach: Der Mauszeiger wird auf dem Bildschirm "direkt" mit einem Finger oder einem speziellen "Pointer-Stylus" (Plastikstiftchen) hin- und her geschoben. Da die Maustasten hier fehlen, werden die Mausklicks durch kurzes und schnelles Antippen / bzw. Gedrückthalten des Stifts für das Kontextmenü an der entsprechenden Stelle des Monitors ersetzt. Touchscreens beherrschen in der Regel auch die Gesten wie Touchpads. Hauptsächlich werden drei unterschiedliche Techniken eingesetzt um die Kontaktpunkte zu erfassen. Es gibt jedoch auch noch weitere Techniken, die jedoch weniger verbreitet sind:

- Resistiver Touchscreen: Zwei elektrisch leitfähige Schichten einer Matrixfolie werden durch den Druck, der mit einem Finger oder dem Stift erzeugt wird gegeneinander gepresst. Durch Messung des elektrischen Widerstandes wird die Stelle ermittelt an der sich die Folien berühren.

- kapazitiver Touchscreen: Hier wird ein Glassubstrat mit Metalloxid beschichtet. Durch das Anlegen von Spannung an den Ecken des Displays wird ein konstantes elektrisches Feld erzeugt. Durch die Berührung kommt es zu einer Entladung die wiederum an den Ecken gemessen werden kann. Ein Controller berechnet dann die genaue Position. Nachteil dieser Bildschirme ist, dass es zu einer Entladung kommen muss. Daher können Sie nur per Hand oder mit speziellen Stiften bedient werden, nicht aber mit den herkömmlichen Stylus-Stiften. Auch eine Verwendung mit Handschuhen (und damit oftmals im Baugewerbe oder in Fabriken) scheidet weitgehend aus. Der Nachteil von kapazitiven Touchscreens ist häufig, dass der Bildschirm häufig mit Fingerabdrücken übersäht ist.

-induktive Touchscreens:

Diese Touchscreens werden häufig bei Grafiktabletts benutzt, denn sie bieten den Vorteil, dass ein aufliegender Handballen keinerlei Reaktion auslöst. Prinzipiell sind sie nur mit einem speziellen Stift mit einer integrierten Spule bedienbar. Die Spule erzeugt per Induktion an der Kontaktstelle eine elektrische Spannung. Ein Controller wertet dann aus wo sich der Stift befindet.

Ein Scanner dient zum Einlesen von auf Papier geschriebenen Informationen. Zuerst jedoch

handelt es sich für den Rechner bei einem Scan lediglich um ein Bild. Es bedarf also einer Spezialsoftware zur Texterkennung (OCR, optical character recognition). Die Resultate sind zudem

nicht immer zufriedenstellend.

Ein Scanner dient zum Einlesen von auf Papier geschriebenen Informationen. Zuerst jedoch

handelt es sich für den Rechner bei einem Scan lediglich um ein Bild. Es bedarf also einer Spezialsoftware zur Texterkennung (OCR, optical character recognition). Die Resultate sind zudem

nicht immer zufriedenstellend.

Die Frage des "richtigen" Monitors ist elementar für das Wohlfühlen am Rechner. Was

ein "richtiger" Monitor ist, lässt in erster Linie aus ergonomischen Gesichtspunkten herleiten. Ein unergonomischer Monitor kann zu Augenproblemen, Kopf- und Rückenschmerzen führen. Entsprechende Tests finden

sich regelmäßig im Internet. Wichtig bei der Monitorauswahl sind neben einer angemessenen Größe (angegeben als Bilddiagonale in Zoll) und Auflösung (angegeben in Pixel der

Bildbreite mal -höhe), das Kontrastverhältnis und die Leuchtstärke. Die früher ebenfalls relevante Reaktionsgeshwindigkeit des Displays ist heute höchstens noch eine Frage bei der

Filmproduktion oder bei extrem schnellen Computerspielen.

Die Frage des "richtigen" Monitors ist elementar für das Wohlfühlen am Rechner. Was

ein "richtiger" Monitor ist, lässt in erster Linie aus ergonomischen Gesichtspunkten herleiten. Ein unergonomischer Monitor kann zu Augenproblemen, Kopf- und Rückenschmerzen führen. Entsprechende Tests finden

sich regelmäßig im Internet. Wichtig bei der Monitorauswahl sind neben einer angemessenen Größe (angegeben als Bilddiagonale in Zoll) und Auflösung (angegeben in Pixel der

Bildbreite mal -höhe), das Kontrastverhältnis und die Leuchtstärke. Die früher ebenfalls relevante Reaktionsgeshwindigkeit des Displays ist heute höchstens noch eine Frage bei der

Filmproduktion oder bei extrem schnellen Computerspielen.

Wenn Sie viel draußen oder direkt an Fenstern arbeiten, sollten Sie ein System mit einer matten ("non-glare") Oberfläche einem spiegelenden ("glare") System vorziehen. Eigentlich sollte ein Monitor nämlich mindestens 75% des auf ihn einfallenden Lichtes absorbieren um eine einigermaßen blendfreie Betrachtung des Bildschirm- Geschehens sicher zu stellen. Nicht spiegelnde Displays, die früher üblich waren, sind heute aber leider nur gegen einen guten Aufpreis erhältlich.

Die gebräuchliche Abkürzung TFT steht übrigens für thin film transistor und bezieht sich auf die Darstellungstechnologie, die Flüssigkristalle zwischen dünnen Folien nutzt, um Bereiche des Bildschirm selektiv abzudunkeln.

Wenn Sie zur Darstellung einen Beamer benutzen, sollten Sie in zweierlei Hinsicht auf die richtige Technologie achten:

|

![]() Artikel "Computermonitor"

Artikel "Computermonitor"![]() Artikel "Videoprojektor"

Artikel "Videoprojektor"

Der Systemlautsprecher sollte bei einem gut eingerichteten, intakten System lediglich dadurch auffallen, dass er nach dem Systemstart einmal kurz piepst. Dieses Piepsen signalisiert, dass der Systemcheck fehlerfrei durchgeführt werden konnte. Nach dem Windows-Start wird seine Funktion fast vollständig von der Soundkarte und Windows-Klangsteuerung übernommen. Doch das Repertoire der möglichen Piepkombinationen reicht viel weiter. So kann er gezielt Auskunft darüber geben, ob Ursache für einen schwarz gebliebenen Monitor bei laufendem Rechner der Monitor selbst oder die Grafikkarte defekt ist. In der Lektion Allgemein Fehlerbehebung habe ich die Piepstöne weiter erklärt und auch einen Link zu Ihrer Bedeutung hinterlegt.

Heute jedoch dominieren zwei Systeme die Welt der Printer: Tintenstrahldrucker und

Laserdrucker, von den Großdruckersystemen wie Thermodruckern oder Offsetdruckmaschinen einmal abgesehen. Das Prinzip des Tintenstrahldrucks ist äußerst einfach. Eine Druckpatrone liefert

Tinte an den Druckkopf. Zuvor wird die Tinte erhitzt bis sie unter hohem Druck steht. Dann werden alle benötigten Düsen geöffnet und die Tinte wird als Punktraster auf das Papier hinausgedrückt.

Die Punktdichte wird hierbei als dpi (dots per inch, Punkte pro Zoll) angegeben. Daneben gibt es ein zweites Tintenstrahlverfahren, das sog. Piezoverfahren bei dem die Tinte mechanisch aus der

Düse herausgedrückt wird. Das Ergebnis ist identisch. Bei Farbpatronen wird die zu druckende Farbe aus den drei Grundfarben zusammengemischt. Daneben gibt es übrigens noch Fototinte, die

intensiver wirkt und leicht andere Reflexeigenschaften aufweist.

Heute jedoch dominieren zwei Systeme die Welt der Printer: Tintenstrahldrucker und

Laserdrucker, von den Großdruckersystemen wie Thermodruckern oder Offsetdruckmaschinen einmal abgesehen. Das Prinzip des Tintenstrahldrucks ist äußerst einfach. Eine Druckpatrone liefert

Tinte an den Druckkopf. Zuvor wird die Tinte erhitzt bis sie unter hohem Druck steht. Dann werden alle benötigten Düsen geöffnet und die Tinte wird als Punktraster auf das Papier hinausgedrückt.

Die Punktdichte wird hierbei als dpi (dots per inch, Punkte pro Zoll) angegeben. Daneben gibt es ein zweites Tintenstrahlverfahren, das sog. Piezoverfahren bei dem die Tinte mechanisch aus der

Düse herausgedrückt wird. Das Ergebnis ist identisch. Bei Farbpatronen wird die zu druckende Farbe aus den drei Grundfarben zusammengemischt. Daneben gibt es übrigens noch Fototinte, die

intensiver wirkt und leicht andere Reflexeigenschaften aufweist.

Das andere große Verfahren hat viele Vorteile gegenüber dem Tintenstrahlverfahren: Es ist leise und schnell. Der Nachteil: Es ist sehr aufwendig und produziert Ozon, das Kopfschmerzen verursachen

kann. Im Gegensatz zum Tintenstrahlverfahren wird beim Laserdruckverfahren die zu druckende Seite vorher bereits komplett im Druckerspeicher aufgebaut. Anschließend wird ein Druckwalze im Drucker

genau an den Stellen elektrostatisch aufgeladen, an denen später das Tonerpulver hängen bleiben soll. Nachdem ein Blatt eingezogen worden ist, wird nun das vorher erhitzte und an der Walze

klebende Tonerpulver auf das Papier aufgebrannt. Dies führt zu einem erheblich schärferen Ausdruck als bei Tintenstrahldruckern. Farb-Laserdrucker liefern die beste Druckqualität. Allerdings

kosten die Drucker mit 250 € und mehr auch deutlich mehr als auch ein einsteiger Tintenstrahldrucker. Wenn Sie Platz sparen wollen, kaufen Sie sich einen All-In-One-Farblaserdrucker der auch

scannen, kopieren und faxen kann.

Dieses Thema könnte Teil jedes meiner Module sein, denn die Anpassung des Rechners für behinderte Menschen kann nicht einzig auf die Hardware beschränkt bleiben. Zunächst werde ich hier eine

Übersicht über die vorhandenen Geräte und anschließend eine Einführung in die software-technische Umsetzung geben. Welche Geräte und Hilfsmittel gibt es?

Menschen, deren körperliche Beweglichkeit eingeschränkt ist, bzw. deren Rezeptionsfähigkeit herabgesetzt ist, sind auf leicht zu bedienende und klar strukturierte Bedien- und

Kommunikationsmöglichkeiten mit dem Rechner angewiesen. Demnach werde ich diese Peripheriegeräte wieder nach Ein- und Ausgabemedien staffeln.

Wie wichtig Eingabehilfen für behinderte Menschen im Bereich der Informationstechnologie sind, unterstreicht ein vom Gesetzgeber in den USA im Jahre 1998 eingeführtes Gesetz. Entsprechend dem Artikel 508 des U.S. Rehabilitation Act müssen alle elektronischen und digitalen Technologien und Produkte, die von der US Bundesregierung eingesetzt werden, auch von behinderten Menschen genutzt werden können. Dies gilt nicht nur für die Entwicklung neuer, sondern auch für Vermittlung und Wartung existierender Technologien und Produkte. Ähnlich werden mittlerweile auch Gesetze in Deutschland erlassen. ("Barrierefreiheitsgesetz") Webseiten von öffentlichen Stellen müssen mittlerweile ebenfalls barrierefrei programmiert sein.

Standardmäßig bietet Windows schon sehr lange Zeit Einstellungsmöglichkeiten an, die benachteiligten Menschen entgegen kommen können. Alleine bei den Maus-Einstellungen kann schon vieles eingestellt werden.

- Das Auffinden der Maus:

Es ist zum Einen möglich den Rechner so einzustellen, dass ein einfaches Drücken der Strg-Taste einen Kreis um den Mauszeiger aufblitzen lässt, der sich kurz darauf immer enger um den Mauszeiger schließt. Zum Anderen kann die Maus mit einer Mausspur versehen werden, die das Verfolgen des Mauszeigers erheblich erleichtert.- Die Bedienung der Maus:

Zu guter Letzt kann die Geschwindigkeit für den Doppelklick verändert werden, um mehr Zeit für die Doppelklickfunktion zu erhalten. Außerdem kann eine Einstellung gewählt werden, die (wie im Internet oder unter Linux) Doppelklicks völligüberflüssig werden lässt.Diese Einstellungen lassen sich hier ändern:

Systemsteuerung öffnen (Start --> Einstellungen --> Systemsteuerung und dort (in der klassischen Ansicht) auf das Icon "Maus" klicken.

Dadurch öffnet sich das folgende Fenster in dem sich dann (gerade auch) über die Reiterleiste die gewünschten Einstellungen vornehmen lassen:

Es gibt eine Reihe guter Spracherkennungs- und Sprachsteuerungssysteme. Der Rechner wird dazu mit der eigenen Stimme über ein Mikrofon gesteuert. Manchmal muss der Rechner dafür angelernt werden, d.h. es wird ein Befehl aufgenommen (ein sog. Sample) und mit dem dazu gehörigen Befehl verknüpft. Gute Systeme kommen aber größtenteils ohne eine lange Anlernphase aus.

Menschen mit nicht vollständig gelähmten Gliedmaßen können den Rechner über einen kleinen Joystick steuern, der entweder mit dem Mund oder mit den Händen (sofern noch möglich) gesteuert wird und quasi die Funktionalität einer Maus besitzt. Unterstützend sind die von Microsoft serienmäßig mit ausgelieferten Hilfsmittel. Vor allem die Bildschirmtastatur ist hier von großem Wert. Dabei wird eine Abbildung einer Tastatur auf dem Monitor erzeugt und die Maus (bzw. das Hilfsgerät) kann durch anklicken der einzelnen Buchstaben "tippen".

Darüber hinaus gibt es noch zahlreiche andere Eingabegeräte (Spezialtastaturen, Stäbchen usw.)

Die bekannteste Ausgabe ist in diesem Fall wohl der vergrößerte Bildschirm per Bildschirmlupe, aber auch Sprach-Synthesizer, die die

Bildschirmausgabe vorlesen können Hindernisse im Umgang mit dem Rechner erleichtern. Trotzdem bleibt gerade im Bereich der Ausgabegeräte

noch ein deutlicher Nachholbedarf vorhanden. Wichtig ist gerade im Bereich der Erleichterungen für Blinde die Kombination aus einem

textuellen Internetbrowser wie "Lynx" [→

Lynx-Entwicklerseite] und einer solche Sprachsynthese. Dadurch können sich sehbehinderte Menschen

Internetseiten "vorlesen" lassen.

[![]() 10]

10]

Mit der gestiegenen Leistungsfähigkeit der Rechnerhardware wird auch im Privatbereich eine Technik interessant, die in Rechenzentren bereits etwas länger eingesetzt wird - die Virtualisierung.

Dabei ergibt sich eine immense Anzahl an Vorteilen und nur äußerst wenige Nachteile. Der Focus von Virtualisierung unterscheidet sich jedoch beim Einsatz von virtuellen Maschinen im Server- oder

im PC-Umfeld.

Eine virtuelle Maschine ist eine Betriebssysteminstallation, die jedoch nicht direkt auf die Hardware zugreift, sondern von einer Zwischenschicht Anteile an einer Ressource zugeteilt bekommt. So

wird der Arbeitsspeicher, die Rechenzeit des Prozessors, Schnittstellen etc. möglichst bedürfnisgerecht auf die virtuellen Maschinen aufgeteilt. Möglich wird das dadurch, dass Betriebssysteme

fast nie direkt mit der Hardware kommunizieren, sondern dies über Gerätetreiber tun, die dies bewerkstelligen und den Zugriff managen. Daher ist es dem Betriebssystem der virtuellen Maschine auch

egal, ob der Treiber den Zugriff auf ein Gerät oder nur den Zugriff auf eine virtuelle Ressource vermittelt.

Kern der Idee bei der Virtualisierung von Servern ist, dass ein physisches Computersystem nicht kontinuierlich unter Volllast läuft. Üblicherweise sind Computer über einen längeren Zeitraum

nur im einstelligen Prozentbereich ausgelastet. Dies führt natürlich zu unnötigen Kosten. Für den Serverbetrieb ergeben sich daraus eigentlich nur zwei Wege.

Die erste Möglichkeit ist, zwei Anwendungen oder Verfahren parallel auf einem Server zu installieren. Manchmal ist das wegen der Kompatibilität nicht möglich, oft aber auch nicht erwünscht, weil

dann einzelne Verfahren in Ihrem Produktionskalender aufeinander Rücksicht nehmen müssten und zum Beispiel eine Anwendung gerade dann ein Update bekommen muss, wenn es für die andere Anwendung

überhaupt nicht in frage kommt den Rechner durchzustarten oder Dienste zu stoppen.

Der zweite Weg ist dann die Einrichtung virtueller Maschinen. Jede Maschine ist eine völlig eigenständige Installation, die einzeln durchgestartet werden kann und sich eigentlich durchgängig wie

ein eigener Server verhält. Dadurch werden andere virtuelle Server nicht in Mitleidenschaft gezogen, wenn eine Maschine bearbeitet oder gar aus einer Sicherung wiederhergestellt wird. Die

Installation auf der physischen Basishardware, auch "Host" genannt, hat in diesem Szenario ausschließlich die Aufgabe, die virtuellen Maschinen - auch "Guests" genannt - zu

verwalten. Nur in den Guests werden Anwendungen betrieben.

Der Fokus beim Einsatz auf einem Personal Computer ist ein anderer als beim Einsatz virtueller Server. Hier geht es nicht so sehr um die Autarkie und das Kostensparen, sondern um die enorme

Flexibilität, die mit VMs erreicht werden kann.

VMs werden gerne genutzt um zum Beispiel Programme oder Funktionen in einer geschützten Umgebung testen zu können ohne gleich ein produktives System verbiegen zu müssen. Außerdem ist es möglich

ein System einzufrieren, dann Änderungen zu testen und es anschließend wieder auf den vorigen Stand zurückzusetzen.

Ein anderer Aspekt, den sogar Microsoft bei Windows 7 aufgegriffen hat, ist die Überwindung von Kompatibilitätsproblemen. So kann ein Programm, das nur mit alten Versionen des Betriebssystems

zusammenarbeitet in einer entsprechenden virtuellen Maschine installiert werden und aus dem aktuellen Betriebssystem heraus genutzt werden. Dies ist sogar nahtlos möglich, das bedeutet es wird

wirklich nur das Anwendungsfenster angezeigt und nicht zwangsläufig der gesamte Desktop der virtuellen Maschine.

Ein netter Nebeneffekt ist auch, dass virtuelle Maschine, die im Hostsystem lediglich als Dateien auftauchen, einfach auf einen anderen Rechner kopiert werden können.

Es gibt eine ganze Reihe von Anbietern virtueller Plattformen. Allerdings haben alle Anbieter leicht andere Schwerpunkte. Für die Virtualisierung von Servern im Rechenzentrumsbetriebs gibt es

derzeit hauptsächlich zwei Anbieter.

Marktführer ist VMWare. Die Virtualisierungsschicht kann sowohl auf Hosts mit Windows als auch mit Linux installiert werden. Neben der kostenlosen Version VMWare Server gibt es auch eine

kostenpflichtige Version, den VMWare ESXi-Server, der weitergehende Möglichkeiten und mehr Flexibilität schafft. Eine große Anzahl an Gastsystemen ist unterstützt und wird mit Treibern versorgt.

Microsoft bietet mit "Hyper-V" ebenfalls ein System zur Virtualisierung an. Mit Windows Server 2008 wurde das System völlig neu implementiert. Hyper-V bietet auch eine Unterstützung

für alle gängigen unixoiden Gastsysteme. Von Microsoft sogar offiziell mit Treibern versorgt werden RedHat und SuSe Linux.

[![]() 11]

11]

Neben der Virtualisierung von ganzen Computersystemen ist auch das Bereitstellen von bloßen Anwendungen verbreitet. Dazu gibt es Angebote von Citrix oder auch von Microsoft (App-V).

Einige der hilfreichen Funktionen ja wurden bereits erwähnt. An dieser Stelle will ich ein umfassendes Bild aller Funktionen zeichnen die Virtualisierung mit sich bringt.

Neben den ganzen Vorteilen, gibt es eine wenige Einschränkungen bei der Verwendung virtueller Systeme. Eine Einschränkung betrifft die Nutzung der Grafikbeschleunigung des Hostsystems. In

einem physischen System erlaubt die Verwendung von speziellen Grafiktreibern wie Direct3D/DirectX den direkten Zugriff auf die Grafikhardware ohne dass die Hardwareabstraktionsschicht des

Windows-Systems genutzt werden muss. Dieser Zugriff muss jedoch exklusiv sein. Die Grafiktreiber einer virtuellen Maschinen können dies nicht realisieren. Daher ist die Wiedergabe von

multimedialen Inhalten, 3D-Inhalten wie Spielen oder CAD-Zeichnungen nur sehr eingeschränkt möglich. Bei virtuellen Desktops wird jedoch nicht die Hardware des im Hintergrund arbeitenden

Serversystems, sondern die des Clientsystems eingesetzt. Hier ist sehr wohl ein Zugriff auf die Grafikhardware machbar und das System eignet sich daher dann doch zur Wiedergabe der beschriebenen

Inhalte.

Wirkliche Einschränkungen sind jedoch erstaunlicherweise keine Technischen. Zum einen gibt es immer noch Hersteller, die ihre Produkte für den Einsatz in VMs schlichtweg nicht freigeben, zum

anderen ist der Einsatz oft von zusätzlichen Lizenzen abhängig. Solche Lizenzen werden zum Beispiel für alle Windows Clientsysteme benötigt, die auf einen virtuellen Desktop mit Microsoft

Clientsystem zugreifen wollen. So eine VDA-Zugriffslizenz kostet neben alle üblichen Lizenzen ca. 100 € und machen oft den Einsatz solcher System unwirtschaftlich.

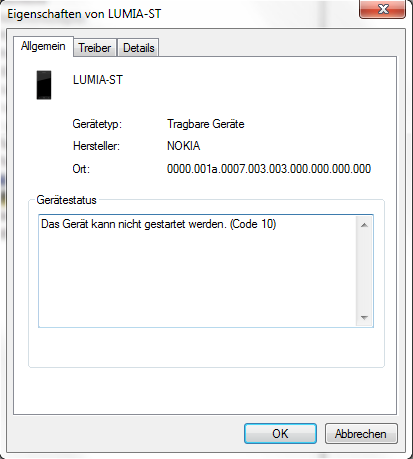

Damit integrierte oder periphere Hardware an einem Rechner funktioniert ist eine Software nötig, die zwischen der Komponente und dem Betriebssystem vermittelt und "übersetzt". Ein Windows System bietet ganz unterschiedliche Stellen an um integrierte oder angeschlossene Hardware und deren Treibersoftware zu verwalten. Geht es jedoch um die Treibersoftware, die der Komponente die Kommunikation mit dem Betriebssystem ermöglicht, ist der Geräte-Manager die erste Anlaufstelle. Den Geräte-Manager erreichen Sie entweder über die Computerverwaltung oder über im Fenster "System", das Sie mit der Tastenkombination Windows + Pause erreichen können. Dort sehen Sie auf der linken Seite dann einen entsprechenden Link. Er wird zur Geräte- und Treiberverwaltung eingesetzt.

Der Geräte-Manager ist wie auch der Windows Explorer als

Baumstruktur aufgebaut. Kategorisiert nach Geräteklassen werden Ihnen alle am Computer angeschlossenen Geräte angezeigt. Wenn Sie im Menü "Ansicht" den Punkt "Ausgeblendete Geräte

anzeigen" aktivieren, werden Ihnen sogar die Geräte angezeigt, die aktuell nicht am Rechner angeschlossen sind, für die es aber bereits eine Treiberinstallation gegeben hat.

Der Geräte-Manager ist wie auch der Windows Explorer als

Baumstruktur aufgebaut. Kategorisiert nach Geräteklassen werden Ihnen alle am Computer angeschlossenen Geräte angezeigt. Wenn Sie im Menü "Ansicht" den Punkt "Ausgeblendete Geräte

anzeigen" aktivieren, werden Ihnen sogar die Geräte angezeigt, die aktuell nicht am Rechner angeschlossen sind, für die es aber bereits eine Treiberinstallation gegeben hat.

Geht es Ihnen nur um diese Übersicht können Sie alternativ auch das Programm "Systeminformationen" (Im Startmenü unter "Alle Programme" --> "Zubehör" -->

"Systemprogramme" oder über die Suchfunktion "msinfo32.exe") starten und sich dort sogar eine druckbare Ansicht ausgeben lassen.

Im Geräten-Manager sehen Sie auch auf einen Blick,

wenn etwas mit einem Gerät nicht stimmt, es nicht funktioniert, in Konflikt mit einem anderen Gerät steht oder deaktiviert worden ist.

Im Geräten-Manager sehen Sie auch auf einen Blick,

wenn etwas mit einem Gerät nicht stimmt, es nicht funktioniert, in Konflikt mit einem anderen Gerät steht oder deaktiviert worden ist.

Das entsprechende Icon bekommt dann ein Ausrufezeichen oder ist rot durchgestrichen. Zur Fehleranalyse klicken Sie mit der rechten Maustaste auf ein solches Gerät und wählen Sie

"Eigenschaften".

Es öffnet sich ein Dialogfeld mit drei Registerkarten. Auf der ersten Registerkarte "Allgemein" gibt es unten einen Bereich "Gerätestatus" Hier erhalten Sie weitere

Fehlerinformationen, nach denen Sie im Internet suchen können.

Manchmal hilft es auch ein Gerät, das nicht mehr funktioniert komplett mitsamt seines Treibers zu löschen und ganz neu erkennen zu lassen.

Wenn Sie eine Hardwarekomponente zum ersten Mal mit Ihrem Rechner verbinden, beginnt Windows automatisch damit die benötigten Treiberdateien im System zu installieren. Im Infobereich neben der

Uhrzeitanzeige wird während der Installation auch ein entsprechendes Symbol angezeigt. Bei dieser sogenannten "Plug&Play"-Installation bedient sich das Betriebssystem der sogenannten

"Device-ID". Diese ID ist für jedes Hardwaregerät einzigartig und macht es möglich zu jeder Hardware eine passende Treiberumgebung zu finden. Nur wenn die ID im Gerät und in der

Treibersoftware identisch sind, wird der Treiber installiert und das Gerät aktiviert.

Bei der Suche nach passender Treibersoftware gibt es eine Reihenfolge:

Im Unternehmensumfeld ist zudem möglich die Suchreihenfolge zu ändern oder Windows Update als Treiberquelle ganz auszuschließen. Dies ist vor allem dann hilfreich, wenn die Unternehmensrechner überhaupt keinen direkten Internetzugriff haben. Sie ersparen Ihren Anwendern damit einige Wartezeit bis der Rechner selbst in einen Timeout läuft.

Steht ein Gerät längere Zeit in der Rubrik "unbekanntes Gerät", dann konnte dafür noch kein Treiber installiert. Zum Installieren eines Treibers (aber auch zum Aktualisieren eines alten Treibers) klicken Sie mit der rechten Maustaste auf das entsprechende Gerät und wählen Sie "Treibersoftware aktualisieren". Danach startet der Hardware-Update-Assistent, dessen Anweisungen Sie nun nur noch folgen müssen. Sollte nach Beenden des Assistenten noch immer kein passender Treiber gefunden werden, bleibt Ihnen noch die Möglichkeiten der eigenen Suche im Internet mittels der Device-ID oder die Auswahl eines Treibers, der nicht für das Gerät geschrieben wurde (aber möglicherweise dennoch funktioniert).

a. Suche mit der Device-ID

a. Suche mit der Device-IDKlicken Sie im Kontextmenü des Geräts auf "Eigenschaften" und danach auf die Registerkarte "Details". Klappen Sie das Dropdown-Menü "Eigenschaft" auf und wählen Sie "Hardware-IDs" aus. Der oberste Eintrag im Feld "Wert" ist nun die am besten passenste Treiberkombination. Sie berücksichtigt sogar Geräterevisionen. Es reicht in der Regel jedoch auch aus nach dem Eintrag ohne "&REV_..." zu suchen um an die passende Treibersoftware zu gelangen.

Warnung

Klicken Sie in den Sucheregebnissen bitte nicht unüberlegt auf jeden Link.

Es gibt eine regelrechte Treibermafia, die sich darauf spezialisiert hat, manipulierte oder vireninfizierte Treiber anzubieten oder Ihnen gleich nur Malware unterzuschieben!

Besser ist es, sich die Sucheregebnisse anzusehen, in denen ein Klarname für das Gerät (am besten mit der Nennung des Herstellers) enthalten ist und anschließend dann auf dessen Internetseite nach dem Treiberdownload zu suchen.

In sehr seltenen Fällen kann es (als allerletzter Ausweg!) funktionieren, einen eigentlich unsignierten oder unpassenden Treiber für ein Gerät zu verwenden.

Die Beispiele, in denen dies sinnvoll sein kann, sind äußerst rar. Zwei möchte ich dennoch hier kurz vorstellen.

- Der Hersteller bietet keinen digital signierten Treiber an

Das folgende Vorgehen funktioniert nur auf 32-Bit-Installationen! Laden Sie den Treiber von der Herstellerseite herunter und extrahieren Sie ihn in ein Verzeichnis Ihrer Wahl. Falls ein Entpacken ohne Weiteres nicht möglich ist, versuchen Sie es mit dem Tool "universal extractor", das Sie leicht über eine Internetsuche finden.

Klicken Sie nun mit der rechten Maustaste auf das Gerät und wählen Sie "Treibersoftware aktualisieren". Es erscheint dieses Dialogfeld:

Klicken nun auf den zweiten Punkt "Auf dem Computer nach Treibersoftware suchen"

Geben Sie einen Pfad zu dem extrahierten Treiberpaket an und stellen Sie sicher, dass der Haken "Unterordner einbeziehen" gesetzt ist. Nach einem Klick auf "Weiter" wird das System versuchen einen Treiber in dem Paket zu finden, der auf Ihr Gerät passt. Es erscheint möglicherweise eine Warnung, dass dem unsignierten Treiber nicht vertraut werden kann. Ignorieren Sie diese Warnung und beenden Sie die Installation. Im Anschluss sollte das Gerät funktionieren.

Windows 64-Bit-Installationen verlangen IMMER signierte Treiber. Diese Anforderung kann nur einmalig für einen Systemstart jeweils im Windows-Bootmanager abgeschatet werden. Daher eignet sich die beschriebene Methode nur auf 32-Bit-Systemen.- Sie haben einen sehr altes Gerät, für das es nur bis Windows XP Treiber gegeben hat und müssen dieses nun unter einem aktuellen Betriebssystem zum Laufen bringen.

Vorsicht!

Das folgende Vorgehen kann zwar zum Erfolg führen, kann aber Ihr Gerät auch beschädigen oder zerstören!

Im Folgenden wird beschrieben, wie sie die Installation eines Treibers erzwingen, der eigentlich für ein anderes Gerät gedacht ist. Wägen Sie sehr gewissenhaft ab, ob Sie an dieser Stelle weitermachen wollen oder ob Sie das Risiko eingehen wollen. Ich stelle diese Informationen daher nur auf Ihr eigenes Risiko hier zu Verfügung.

Wenden Sie den folgenden Weg niemals bei Festplatten und Raid-Treibern an!

Es drohen Ihnen Hardwareschäden oder Datenverluste, die Sie möglicherweise erst nach langer Zeit bemerken.

Wenn Sie dennoch fortfahren wollen, sollten Sie wissen, dass sich mit Windows Vista einiges am Treibermodell geändert hat und dass Windows XP-Treiber daher grundsätzlich nicht mehr einsetzbar sind. Zwischen Windows Vista und Windows 7 gibt es in der Regel keinen Unterschied, sodass die Treiber in beiden Fällen funktionieren dürften. Mit Windows 8 hat sich zwar erneut etwas am Treibermodell geändert, allerdings können Windows 8 und auch Windows 8.1 mit den Treibern, die mindestens für Windows Vista geschrieben worden sind, umgehen.

Wie gesagt, der letzte valide Treiber für Ihr Gerät war ein Windows XP Treiber. Möglicherweise gab es jedoch ein Nachfolge- oder Schwestermodell, das weitgehend baugleich war oder nur wenig überarbeitet wurde. Wenn es für dieses Modell aktuellere Treiber gibt, wäre es möglich deren Einsatz auszuprobieren. Laden Sie die Treiber nun herunterr und entpacken Sie sie soweit möglich. Nutzen Sie gegebenfalls den bereits genannten Universal Extractor. Eine Installation durch die Setup-Routine wird definitiv an der Modellüberprüfung scheitern und kann daher direkt übergangen werden.

Klicken SIe im Geräte-Manager nun in den Geräte-Eigenschaften auf die Registerkarte "Treiber" und dort "Treiber aktualisieren". Es erscheint wieder folgendes Dialogfeld:

Hier klicken Sie wie bereits im obigen Fall auch auf "Auf dem Computer nach Treibersoftware suchen" und erscheint folgende Ansicht:

Hier wählen Sie nun "Aus einer Liste von Gerätetreibern auf dem Computer auswählen". Der Rechner beginnt dann eine Liste aller Treiber aufzubauen. Dies dauert etwas.

Entfernen Sie den Haken bei "Kompatible Hardware anzeigen" und klicken Sie dann auf "Datenträger". Es öffnet sich ein kleineres Dialog "Installation von Datenträger". Navigieren Sie zum Ordner mit dem Treibern und bestätigen Sie alle Abfragen. Zurück im vorherigen Dialogfeld können Sie nun auch alle Geräte auswählen, die eigentlich ungültig sind, wobei Sie den Treiber des identizierten "Schwestermodells" auswählen sollten. Etwaige Warnungen, wären an dieser Stelle wieder zu ignorieren.

Klicken Sie danach auf "Weiter" und bestätigen Sie alle weiteren Warnungen.

Sollte die Installation es Treibers durchlaufen, funktioniert das alte Gerät möglicherweise nach einem Systemneustart.

[1][URL: http://www.heise.de/newsticker/Casemodding-Mit-Fantasie-gegen-Computer-Tristesse--/meldung/144119]

[2] [URL: http://de.wikipedia.org/wiki/Universal_Serial_Bus#USB_3.0a]

Datum der letzten Recherche: 14.09.2014 14:00 Uhr

[3]Der "Die" bezeichnet einen Chip ohne eigenes Gehäuse. Der Begriff stammt aus dem Englischen. Zur Begriffsherkunft vergleiche

[a] PC-Technik für Systembetreuer, RRZN, 4. Auflage

[URL:

http://de.wikibooks.org/wiki/Computerhardware_f%C3%BCr_Anf%C3%A4nger:_Prozessor]

Datum der letzten Recherche 02.05.2007 15:44 Uhr

[b]Wikipedia (Deutschland) Artikel Die (Halbleitertechnik)

[URL:

http://de.wikipedia.org/wiki/Die_%28Halbleitertechnik%29]

Datum der letzten Recherche 15.05.2008 09:24 Uhr

[4] Beim Bus handelt es sich um "parallel verlaufende Leitungen", hier zwischen Prozessor und Arbeitsspeicher, die für Adressen, Steuersignale und Arbeitsdaten als Transportmedium

dienen. Entsprechend die Bezeichnungen: Adressbus, Steuerbus, Datenbus. Je nach Zahl der Leitungen (meist 32, 64 oder 128) spricht man von 32-Bit-Bus, 64-Bit-Bus, 128-Bit-Bus oder von einer

32-Bit-Architektur, 64-Bit-Architektur oder 128-Bit-Architektur. usw... Meist wird die 32-Bit-Archtektur mit x86 (vom ersten PC-Prozessor 8086) und die 64-Bit-Architektur mit x64 abgekürzt,

vergleiche

[URL: http://de.wikipedia.org/wiki/Bus_%28Datenverarbeitung%29]

Datum der letzten Recherche 21.09.2014 17:25 Uhr

[5] Wikipedia (Deutschland)

[URL: http://de.wikipedia.org/wiki/Basic_Input_Output_System]

Datum der letzten Recherche: 16.06.2008 08:21 Uhr

[6] Wikipedia (Deutschland)

[URL http://de.wikipedia.org/wiki/EPROM ]

Datum der letzten Recherche: 16.06.2008 08:45 Uhr

[7] Wikipedia (Deutschland)

[URL http://de.wikipedia.org/wiki/UEFI]

Datum der letzten Recherche: 14.09.2011 11:05 Uhr

[8] Wikipedia (Deutschland)

[URL: http://de.wikipedia.org/wiki/Vergleich_optischer_Datenträger]

Datum der letzten Recherche 15.05.2008 15:11 Uhr

[9 Informationen zum Thema Eingabehilfen befinden sich auch auf der Microsoft Webseite unter:

[URL:

http://www.microsoft.com/enable/]

[10] Wer selbst einmal die Internet-Welt mit Lynx sehen will kann dies hier tun:

Delorie, DJ [URL:

http://www.delorie.com/web/lynxview.html]

[11] Microsoft-Technet

[URL: http://technet.microsoft.com/en-us/library/cc794868%28WS.10%29.aspx]

Datum der letzten Recherche: 24.07.2011 13:00 Uhr

| Letzte Aktualisierung 10.04.2025 | |

| © by Stefan Klebs (2004-2025) (für den Kurs 2002-2025) |